豪掷80亿好意思元后,亚马逊“绑死”Anthropic,要建巨匠最大AI蓄意集群。

巨匠最大云蓄意巨头,掏出硬核家底!

智东西12月3日拉斯维加斯报谈,在年度云蓄意产业嘉会AWS re:Invent大会上,AWS(亚马逊云科技)邻接发布6款大模子、预报2款大模子,还推出3nm第三代AI教训芯片Trainum3偏执迄今最强AI服务器Trn2 UltraServer。

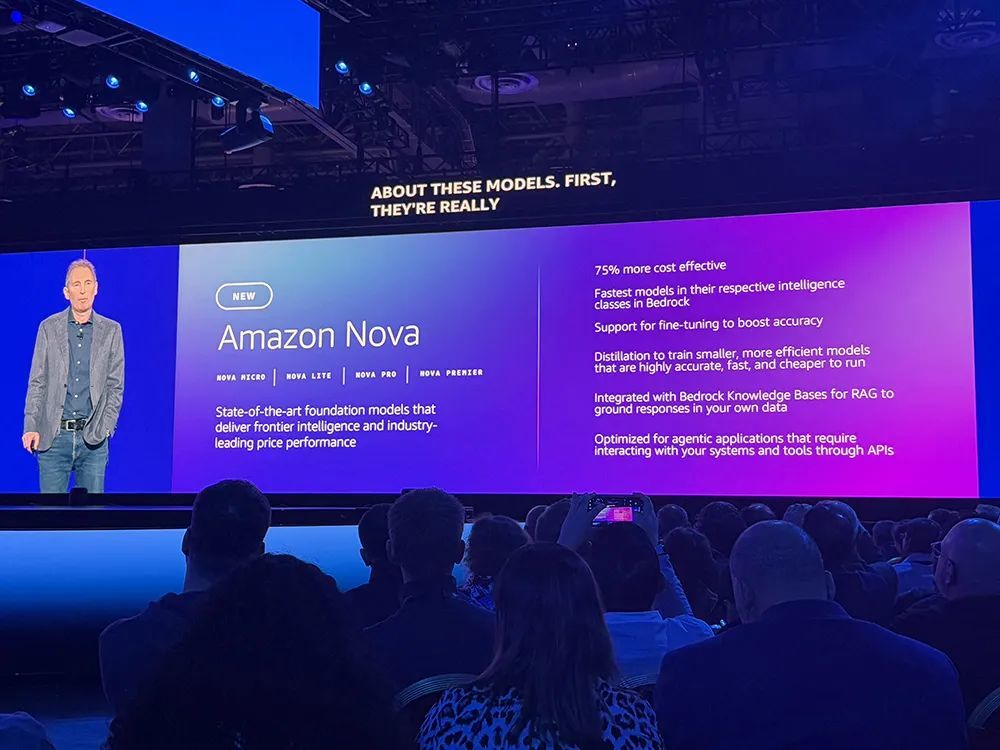

这是Amazon Nova系列基础模子初度亮牌。

包括Micro、Lite、Pro、Premier四个版块的话语模子,还有图像生成模子Canvas、视频生成模子Reel。其中Reel现支执生成6秒视频,很快将会延长到2分钟。

亚马逊总裁兼CEO安迪·贾西现场剧透:来岁,AWS不仅将发布语音转语音模子,还有更高能的大肆转大肆(Any-to-Any)模子——能输入和输出文本、图像、音频、视频等任何模态的内容。

这些模子均在Bedrock中提供,可微统一蒸馏。

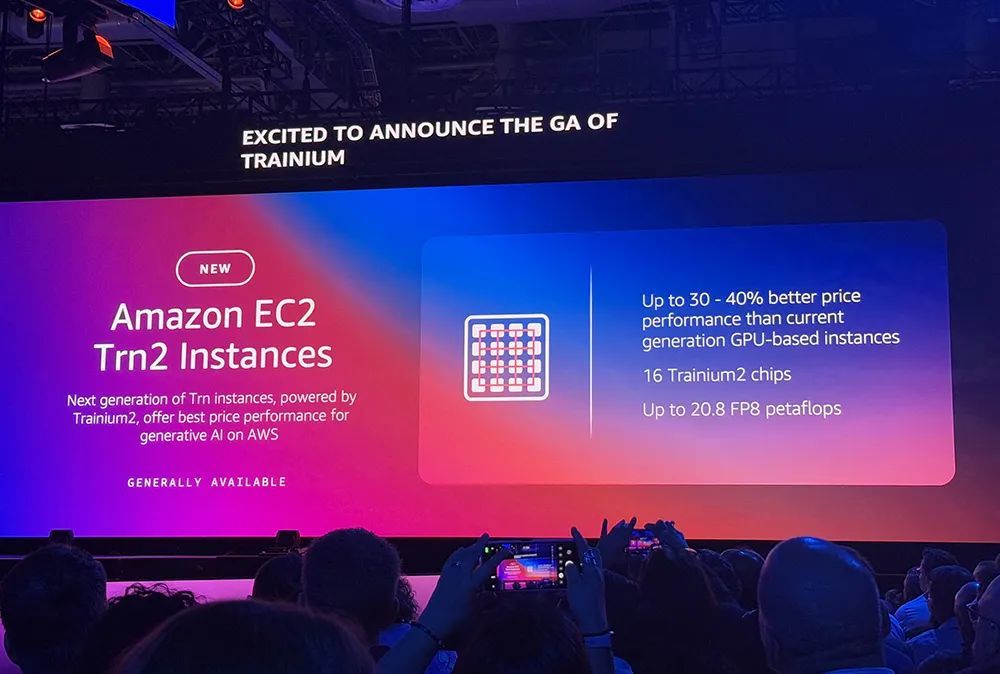

此外,AWS CEO马特·加曼告示推出最重生成式AI实例Amazon EC2 Trn2,比现时基于GPU的EC2实例的性价比高出30%~40%。

苹果机器学习和东谈主工智能高档总监Benoit Dupin来到现场,称苹果在iPad、Apple Music、Apple TV、新闻、App Store、Siri等居品和服务上平方使用了亚马逊服务。

他很是共享谈,与x86实例比较,苹果已用Amazon Graviton、Inferentia等AWS芯片在机器学习推理职责负载方面达成了40%以上的后果晋升,并展望在Trainium 2上预教训模子时,后果将提高50%。

被亚马逊豪掷80亿好意思元投资的Anthropic,告示与AWS共同构建面向机器学习教训的天下最大蓄意集群,其下一代Claude大模子将在领罕有十万颗Trainium2芯片的集群上进行教训。

总体来看,AWS的蓄意、存储、数据库、AI推理,四大板块都迎来一大波关键更新。

01.全新自研大模子Amazon Nova系列登场!文本、图像、视频都活了

亚马逊总裁兼CEO安迪·贾西现场共享了生成式AI如何联合亚马逊不同行务,包括改善了电商客服、卖家信托页创建、库存照管、机器东谈主、Alexa、Amazon Lens、线上购物衣裳尺码匹配、Prime Video等的后果和体验。

然后,他公布全新大模子系列——Amazon Nova!

Nova话语模子有四款:

(1)Micro:纯文本模子,128k荆棘文窗口,延长最低,反应速率最快。

(2)Lite:资本很低的多模态模子,300k荆棘文窗口,可快速处理图像、视频和文本输入。

(3)Pro:多模态模子,300k荆棘文窗口,兼顾准确度、速率和资本,能进行视频相识、生成创意素材。

(4)Premier:亚马逊功能最强的多模态模子,可用于现实复杂的推理任务,并可用作蒸馏自界说模子的最好真挚(将于2025年第一季度推出)。

据先容,Micro、Lite和Pro的价钱至少比Amazon Bedrock中各自智能类别中性能最好的模子低廉75%。它们亦然Amazon Bedrock中各自智能类别中速率最快的模子。

AWS称到2025岁首,某些Nova模子的荆棘文窗口将彭胀以支执卓越200万个token。

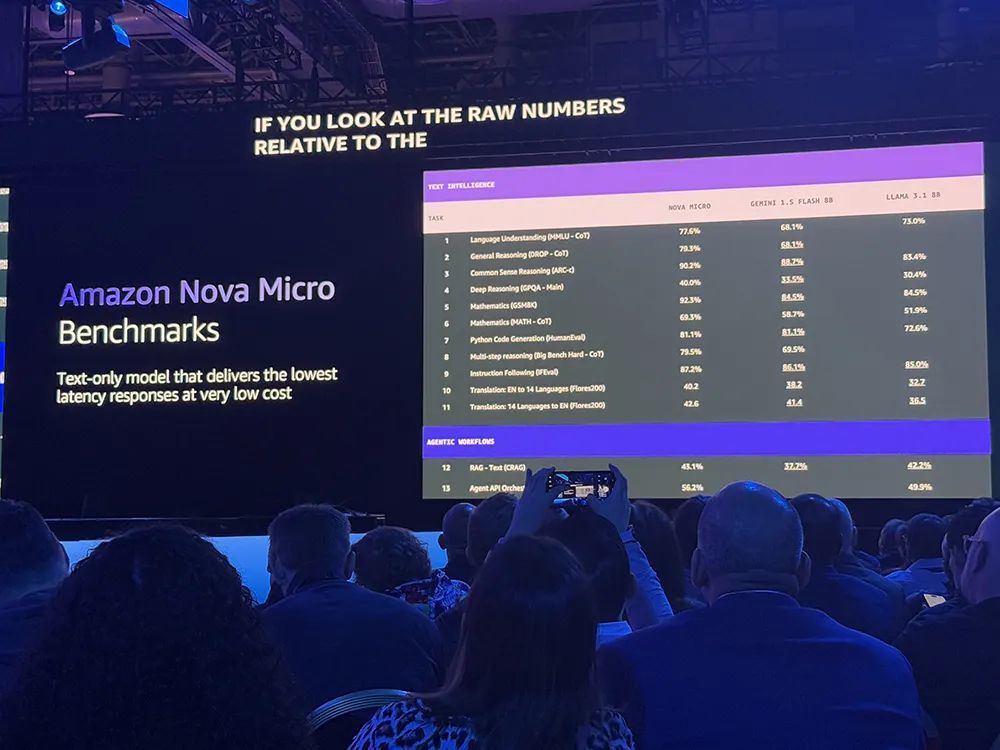

在基准测试中,Micro版合座性能卓越Gemini 1.5 Flash 8B和Llama 3.1 8B。

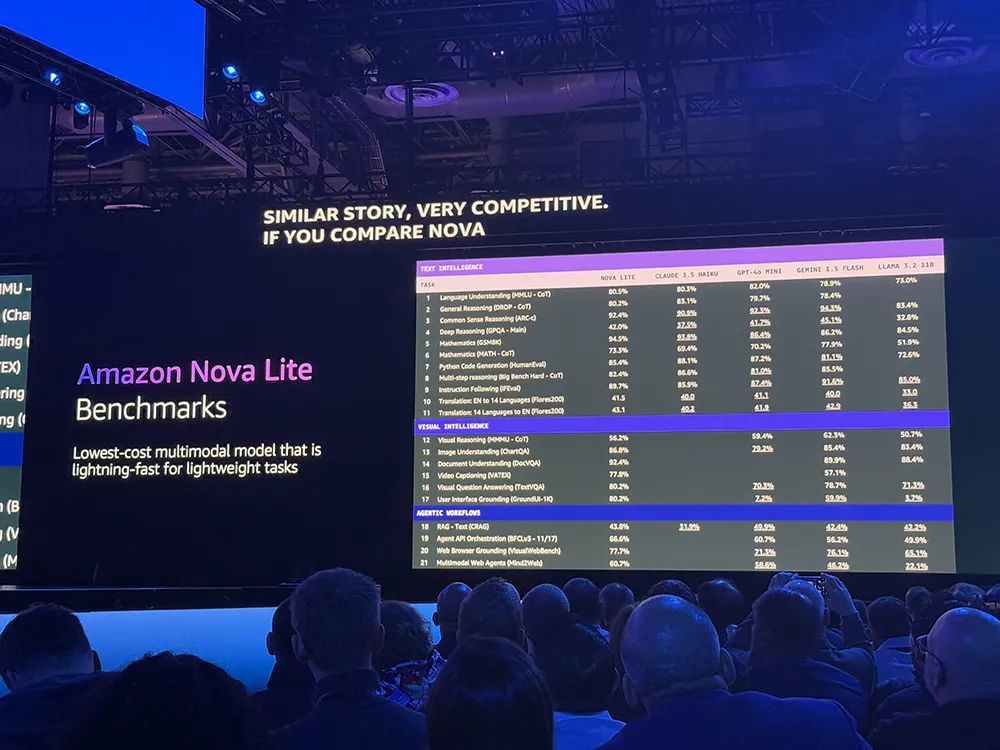

Lite在处理轻量级任务时是最低资本的多模态模子。

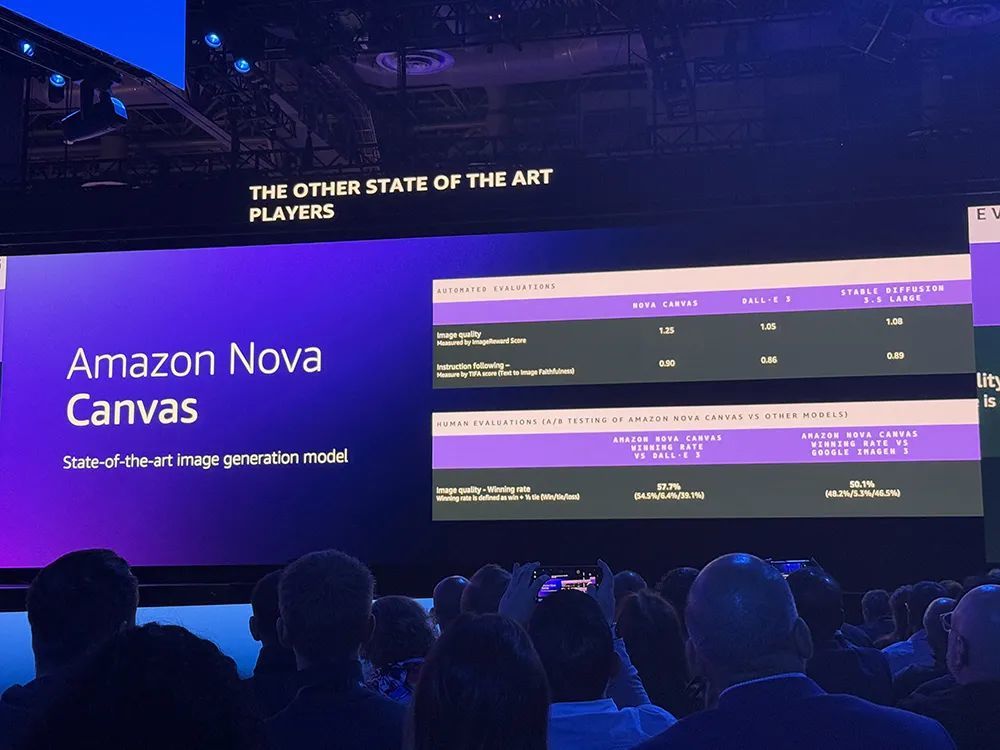

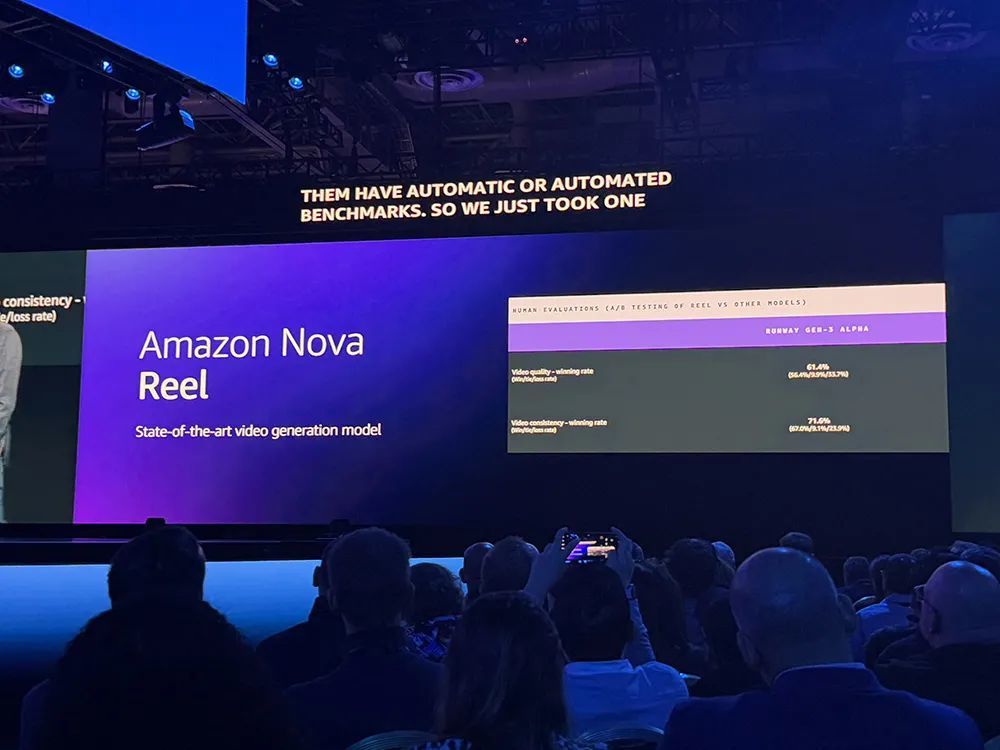

新发布的另外两个Nova模子是图形生成模子Canvas和视频生成模子Reel,可用于晋升宣传告白的创意。

Canvas支执生成和裁剪图像,提供配色有酌量和布局控件,并内置有安全控件,用于可回首性的水印和用于限制无益内容生成的内容审核。

Reel可凭证要津词或可选的参考图像生成6秒视频,支执用户诊治录像机通顺以生成具有平移、360度旋转和缩放的视频。可制作2分钟视频的版块行将推出。

用Amazon Nova Reel创作的视频示例

这些模子支执自界说微统一蒸馏。

还有One More Thing:

AWS将在来岁推出另外两款Nova模子,一款是“语音转语音”模子;另一款是“大肆转大肆”多模态模子,其输入和输出不错是文本、图像、音频或视频,也即是能用归并个模子现实多样任务。

除了发布自研模子,AWS也公布了跟Anthropic的合作新推崇。

AWS与Anthropic合作推出了Claude 3.5 Haiku延长优化版,将推理速率提高60%。

客户只需翻开API的开关,央求就会被发到新的Trainium2服务器上。

Amazon Bedrock提供的延长优化选项,支执客户拜谒其最新AI硬件和其他软件优化,以取得模子的最好推感性能。除了Claude模子外,还包括Llama 405B和较小的Llama 270B模子,处理请乞降生成相应的总耗时比其他居品低得多。

02.AWS Trainium2实例全面推出,发布第三代AI教训芯片、最强AI服务器

AWS全面推出由Trainium2芯片驱动的Amazon EC2 Trn2实例,比较现时基于GPU的EC2实例,性价比高出30%~40%。

全新Amazon EC2 Trn2实例专为包括谣言语模子和潜在扩散模子在内的生成式AI高性能深度学习教训而构建。

其AI硬件全家桶也哐哐上新,推出第三代自研AI教训芯片Trainium3,还发布了其史上最强AI服务器Trn2 UltraServer。

1、第三代自研AI教训芯片

AWS发布了新一代AI教训芯片Trainium3。这是首款收受3nm工艺节点制造的AWS芯片,能效提高40%、性能翻倍晋升。

搭载Trainium3的UltraServer性能展望将比Trn2 UltraServer高出4倍。首批基于Trainium3的实例展望将于2025年底上市。

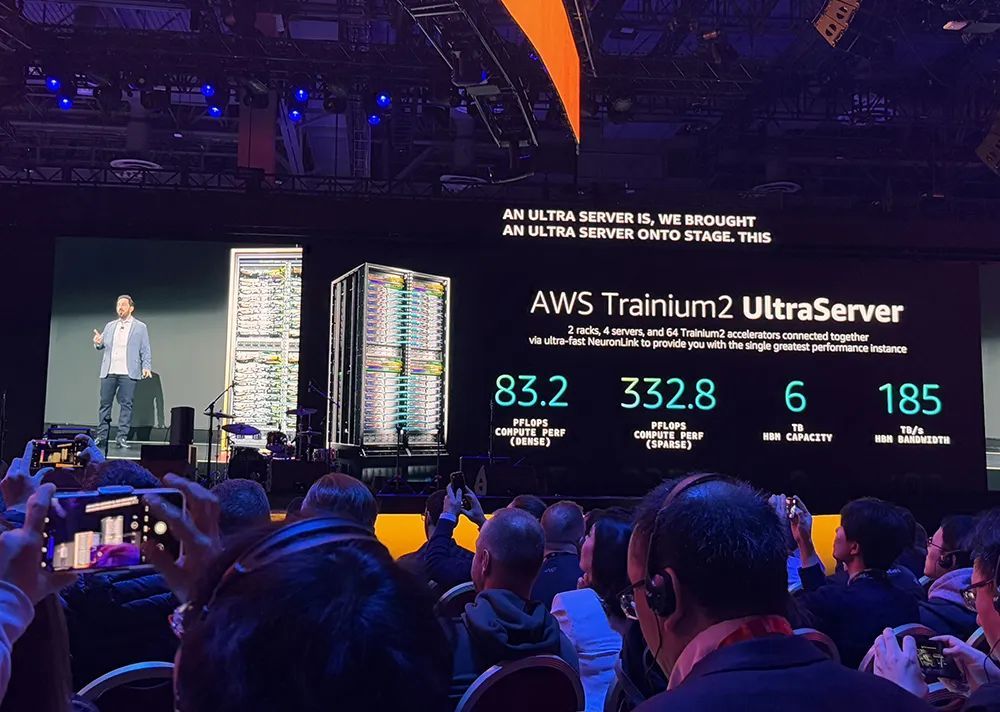

2、最强AI服务器,64颗Trainium2合体

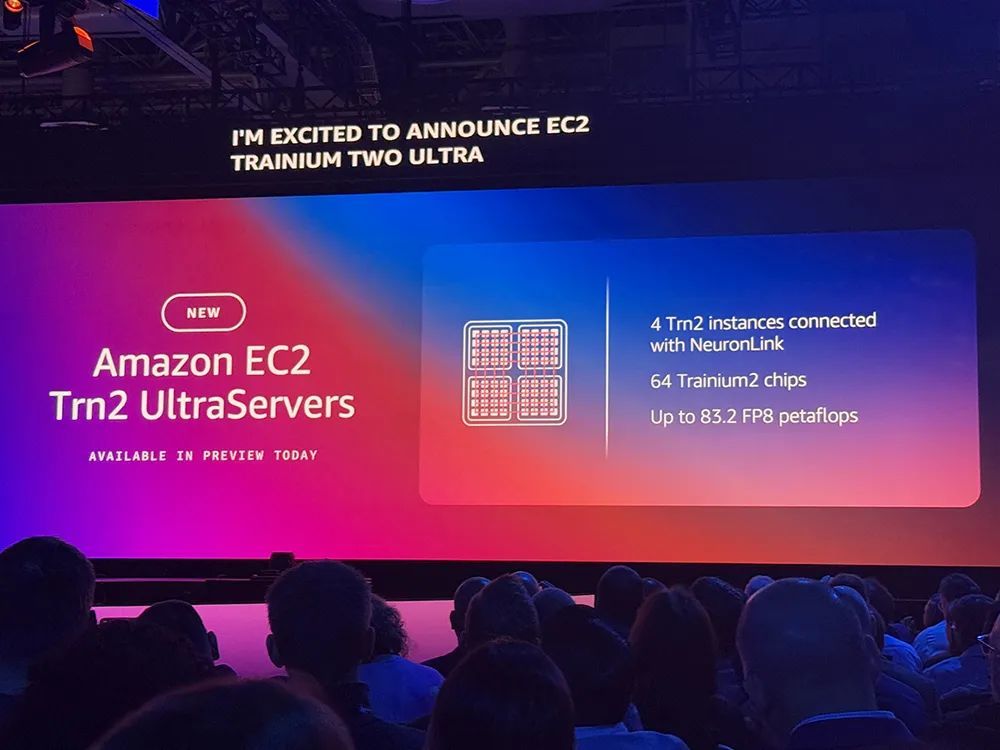

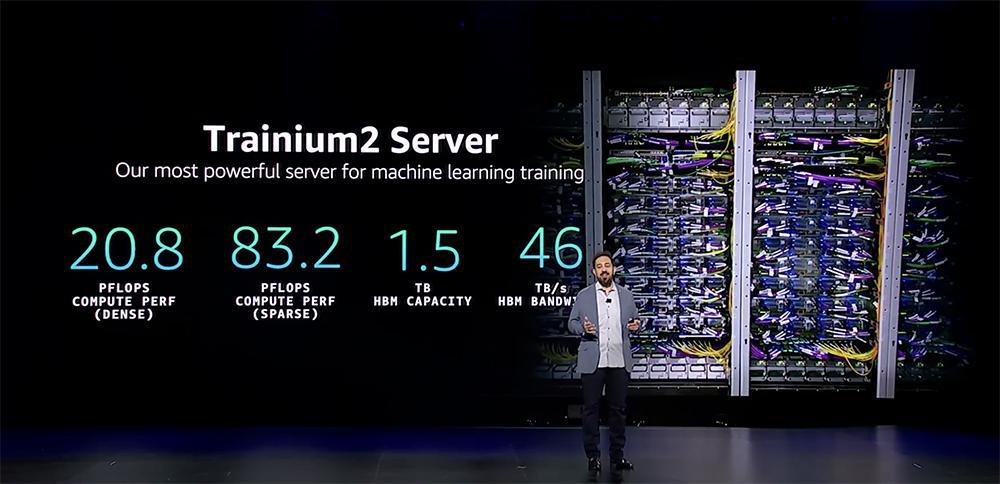

AWS发布其史上最强AI服务器AWS Trn2 UltraServer,能相沿万亿参数AI模子的及时推感性能。

全新Trn2 UltraServer使用超高速NeuronLink互连,将4台Trn2服务器结合在一都,酿成1台巨型服务器,达成更快的大模子教训和推理。

单个Trn2实例结合了16颗Trainium2芯片,可提供20.8PFLOPS,稳妥教训和部署罕有十亿个参数的谣言语模子。

全新EC2居品Trn2 UltraServer则将64颗Trainium2芯片互连,可提供比较现时EC2 AI服务器多达5倍的算力和10倍的内存,将FP8峰值算力彭胀到83.2PFLOPS(单个实例的4倍)。

AWS已与Adobe、AI软件开采平台Poolside、数据分析平台Databricks、高通等几个早期客户进行了Beta测试培训。

3、与Anthropic扩大合作,要建巨匠最大AI蓄意集群

好意思国AI大模子独角兽Anthropic的联合独创东谈主兼CTO Tom Brown现场共享说,就像俄罗斯方块游戏,机器里面构造越高超,跑模子就越低廉越快。一年多来,Anthropic性能工程团队与亚马逊和Annapurna团队密切合作,搪塞这一挑战。

他告示AWS与Anthropic正合作构建一个名为Project Rainier的Trn2 UltraServers EC2 UltraCluster,它将在数十万颗Trainium2芯片上彭胀散播式模子教训。

这些芯片与第三代低延长PB级EFA网罗互连,是Anthropic用于教训其现时一代起原AI模子的百亿亿次浮点运算数目的5倍多。

建成后,展望它将成为迄今天下上最大的AI蓄意集群,可供Anthropic构建和部署其改日模子。

使用Project Rainer后,用户将概况以更廉价钱、更快速率取得更多智能、更聪惠的Agent。

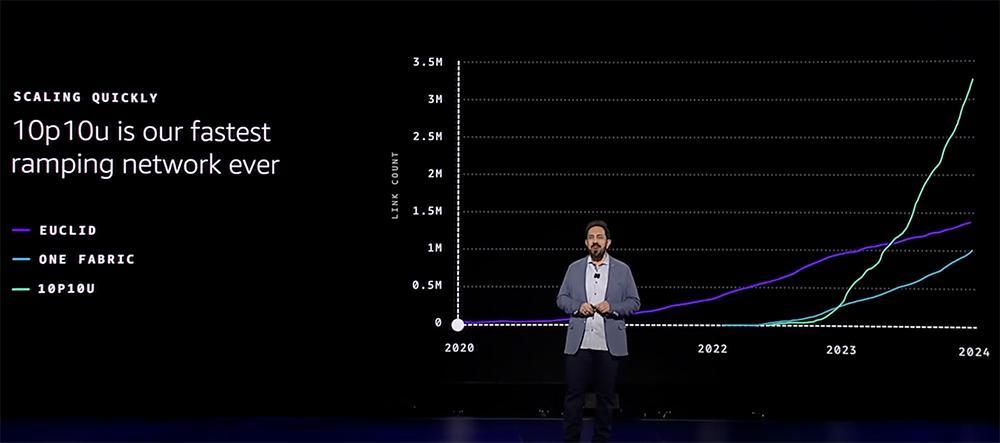

4、新一代AI网罗结构tnp10

为Trainium2 UltraServer提供能源的是最新一代AI网罗结构tnp10。AWS在基于Trainium和NVIDIA芯片的集群都使用了这个网罗。它能在10微秒延长下为数千台服务器提供数十PB网罗容量,达成了AWS迄今彭胀速率最快的网罗。

Tnp10网罗的大范围并行、高超互联和弹性的,可收缩到几个机架,也不错将其彭胀到卓越多个物理数据中心园区的集群。

AI网罗中的最大故障来源是光链路。多年来,AWS一直在假想和运行自家定制光学系统,以执续镌汰故障率。为了进一步优化网罗,AWS在tnp10网罗中建造了一个全新的网罗路由条约“可彭胀意图驱动路由(CIDR)”,通过分散的速率和弹性提供了鸠合的酌量、戒指和优化。

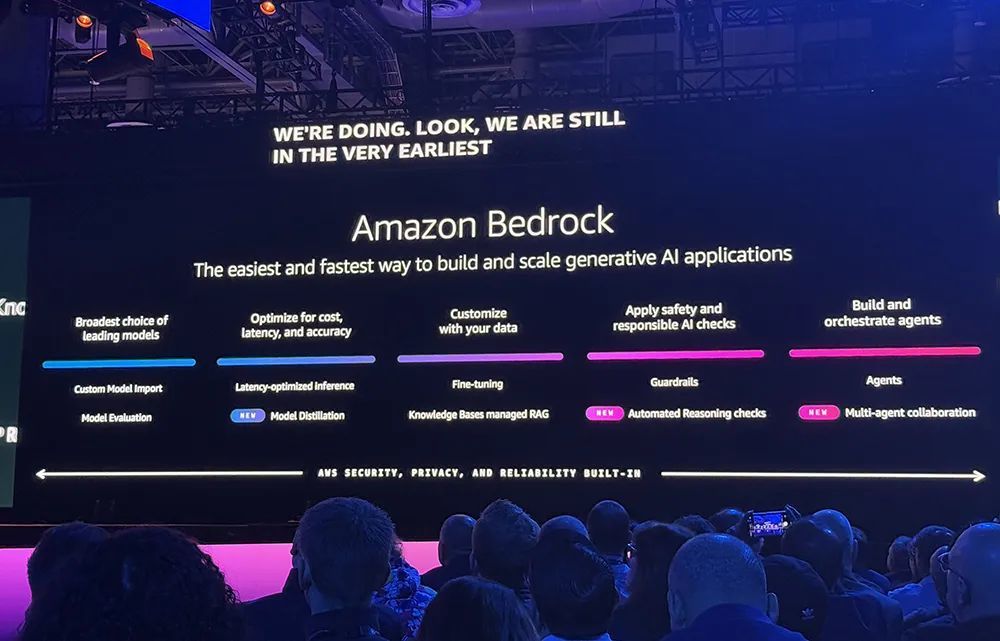

03.生成式AI平台Bedrock服务三大更新:自动推理查验、多Agent协同、模子蒸馏

AWS Bedrock服务可匡助企业构建和彭胀生成式AI应用模范,今天公布对于自动推理查验、多agent配合、模子蒸馏的新功能。

AWS将Bedrock标榜为“构建生成式AI应用的最苟简步地”。据加曼表露,每天都有无独有偶的客户将Bedrock用于分娩应用模范,这简直是旧年一年增长率的5倍。

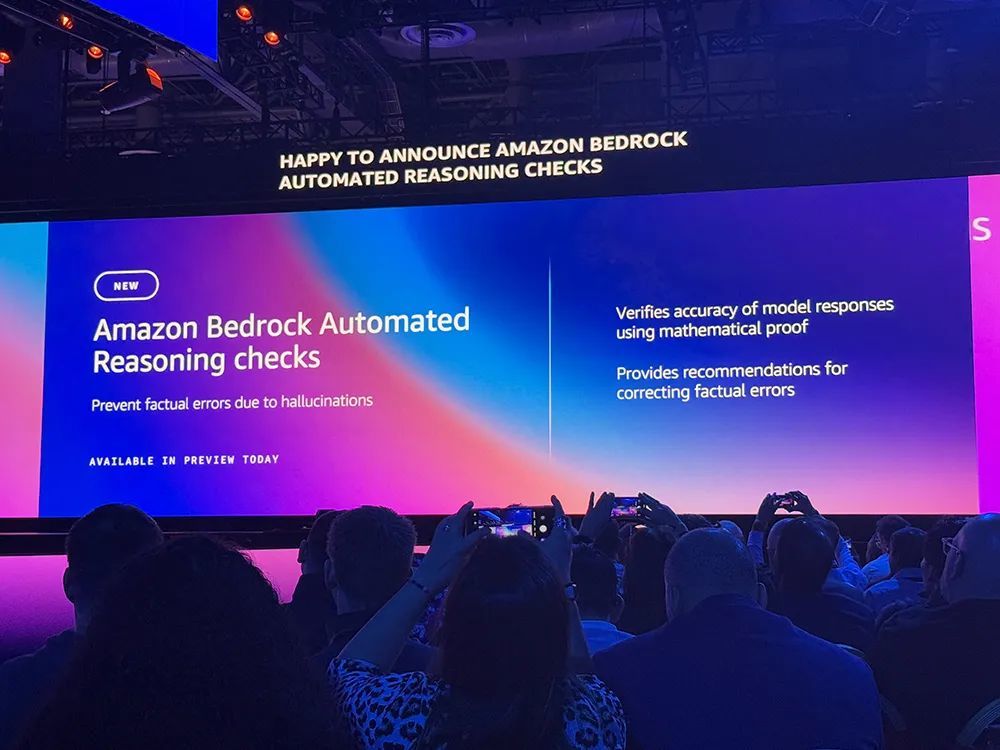

1、自动推理查验,可退守AI幻觉

AI幻觉是妨碍AI应用进入企业本色分娩的要津。AWS在探索历程中发现,自动推理不错被应用于科罚这个问题。自动推理频频用于阐明系统是否按指定步地职责。这个器用不错自动查验有酌量和软件,考证在碰到不测事件时如何正确反应等。

基于此,AWS推出了AWS Automated Reasoning checks,可考证事实反应的准确性、生成可审计的输出,并向客户展示模子得出扫尾果然切原因。

同期,Amazon Bedrock会自动制定必要的礼貌,迷惑客户对其进行迭代测试,以确保模子诊治到正确的反应。

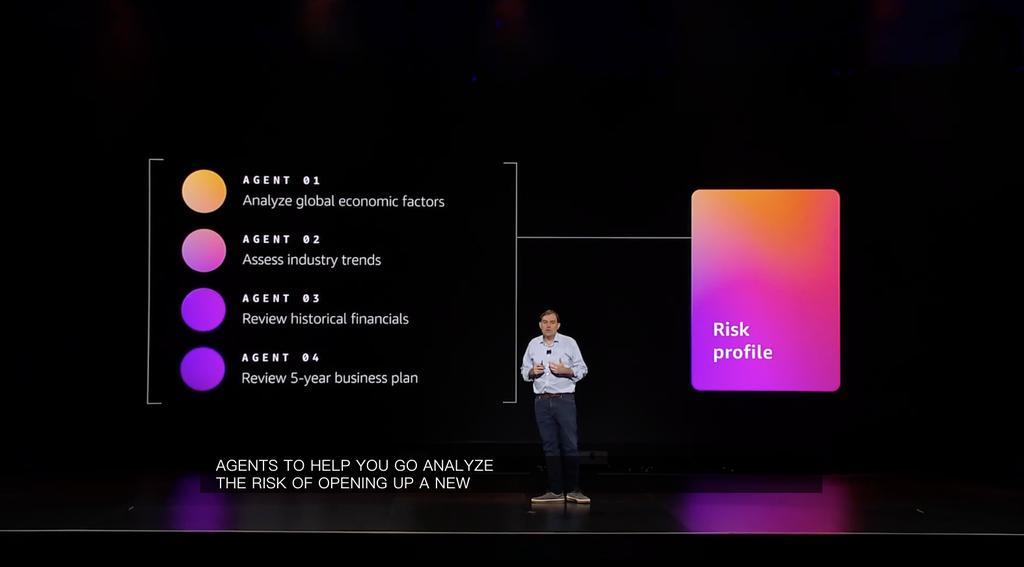

2、多Agent配合,1小时完成此前1周任务

Bedrock的新功能还有匡助企业疏忽构建、部署、编排agent团队,使其写稿科罚复杂多法子任务。

使用Amazon Bedrockmulti-agent collaboration,企业可通过为名主见特定法子创建和分拨稀奇Agent来取得更准确的扫尾,并通过融合多个并行职责的Agent来加快任务。

比如企业不错在Bedrock上构建我方的专科Agent,然后创建主宰Agent或融合Agent来匡助照管其他Agent。

AWS的客户称,这种多Agent配合使其此前需要约莫1周技艺的疏浚任务,当今不错在1小时内完成。

3、模子蒸馏,速率最高晋升500%

当下每周都有新版块的模子发布,企业需要基于我方的本色需求找到更稳妥的模子,需要稳妥的专科学问、稳妥延长、稳妥伙本以完成任务。

企业面前科罚的有酌量之一是模子蒸馏,将性能广大的基础模子中的数据和谜底拿出来教训更小的模子,这需要企业对教训数据进行照管,黄金投资并同期计议到模子参数和权重的问题。

借助Amazon Bedrock Model Distillation,客户只需针对给定用例采选最好模子,并从归并模子系列中采选较小的模子,即不错合适的资本提供其应用模范所需的延长。

与原始模子比较,蒸馏模子速率最高可提高500%,运行资本镌汰75%,对于检索增强生成(RAG)等用例,准确度耗损不到2%。

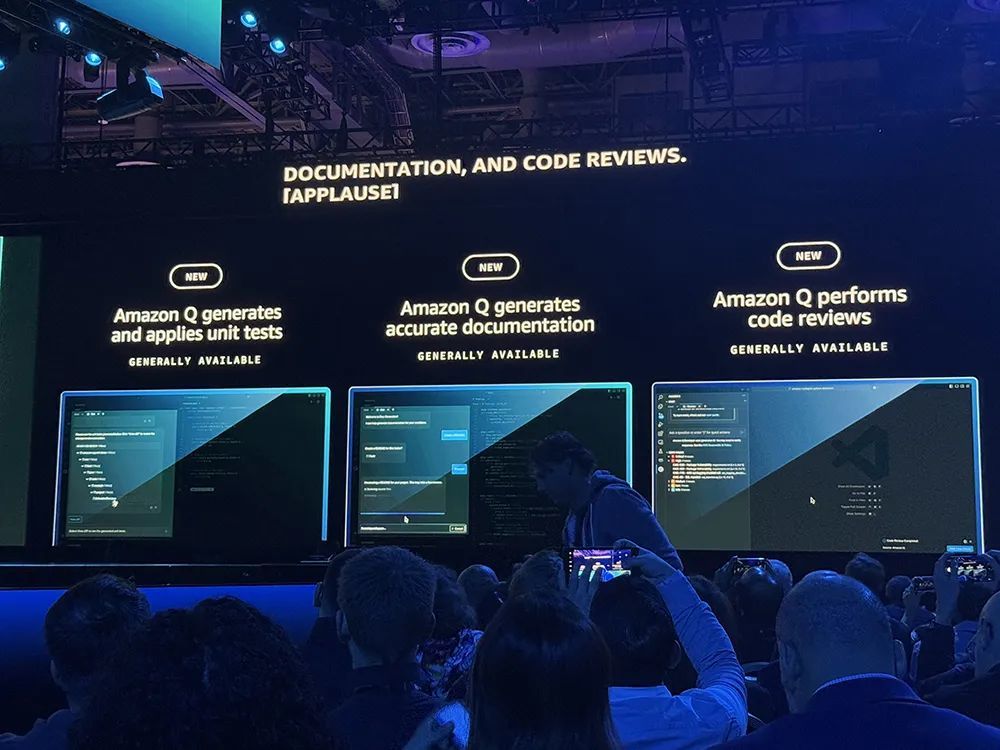

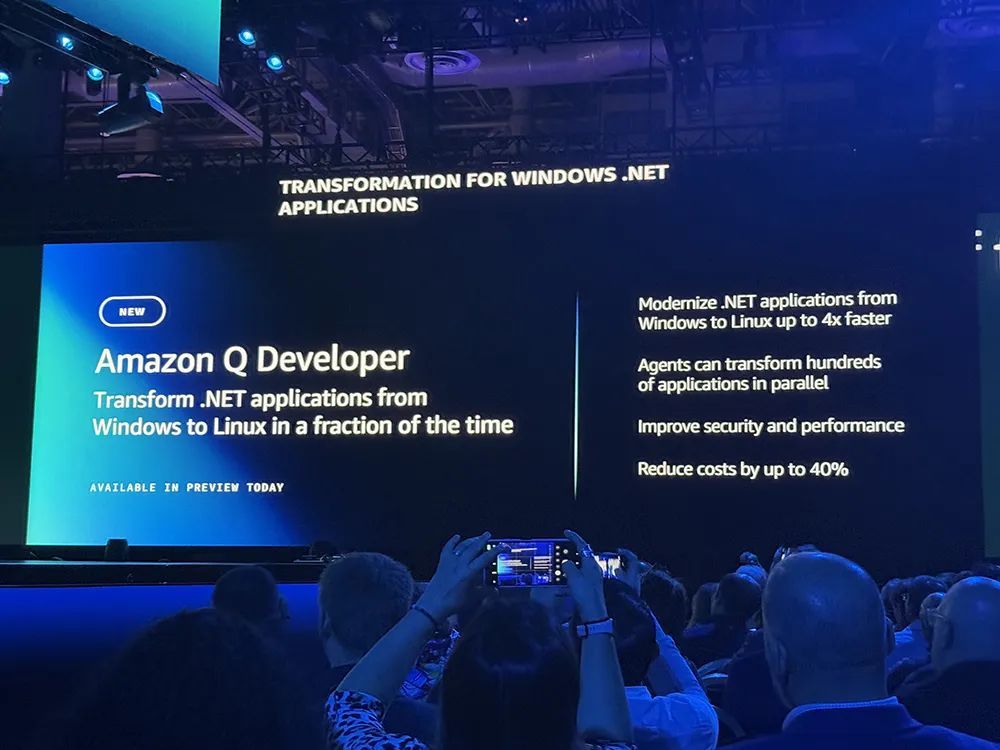

04.Amazon Q Developer超越代码,清除更平方开采任务

Amazon Q Developer提拔编程平台这次升级的要点是超越代码完成,匡助开采东谈主员完成端到端软件生命周期中波及的更平方日常任务。

Amazon Q Developer的新功能主要包括:

将Windows .NET应用模范当代化为Linux,速率提高4倍,并将许可资本镌汰多达40%。

将VMware职责负载转化为云原生架构,agents自动野心、鉴识、决定和迁徙网罗树立,在数小时内将腹地网罗树立迁徙为AWS等效树立。

通过简化代码分析、文档、野心和重构应用模范等劳动密集型职责来加快大型机当代化。

Q Developer现可自动生成单位测试,并匡助开采东谈主员编写和迁徙代码文档。它不错生成第一个代码审查,供开采东谈主员提打发码时使用。一朝代码参加分娩,Q的新运营Agent就自动从公司的监控服务AWS CloudWatch中索求数据,并在警报响起时立即开动侦察。

AWS还推出了一款用于当代化COBOL大型机应用模范的Agent。

此外,开采东谈主员和安全平台GitLab和AWS告示已联手将GitLab的Duo AI助手与亚马逊的Q自主Agent结合起来。GitLab用户可用Duo的聊天功能拜谒Amazon Q Developer中提供的好多Agent,以匡助进行代码审查、生成单位测试和当代化他们的Java应用模范,该功能当今已平直集成到GitLab聊天UI中。

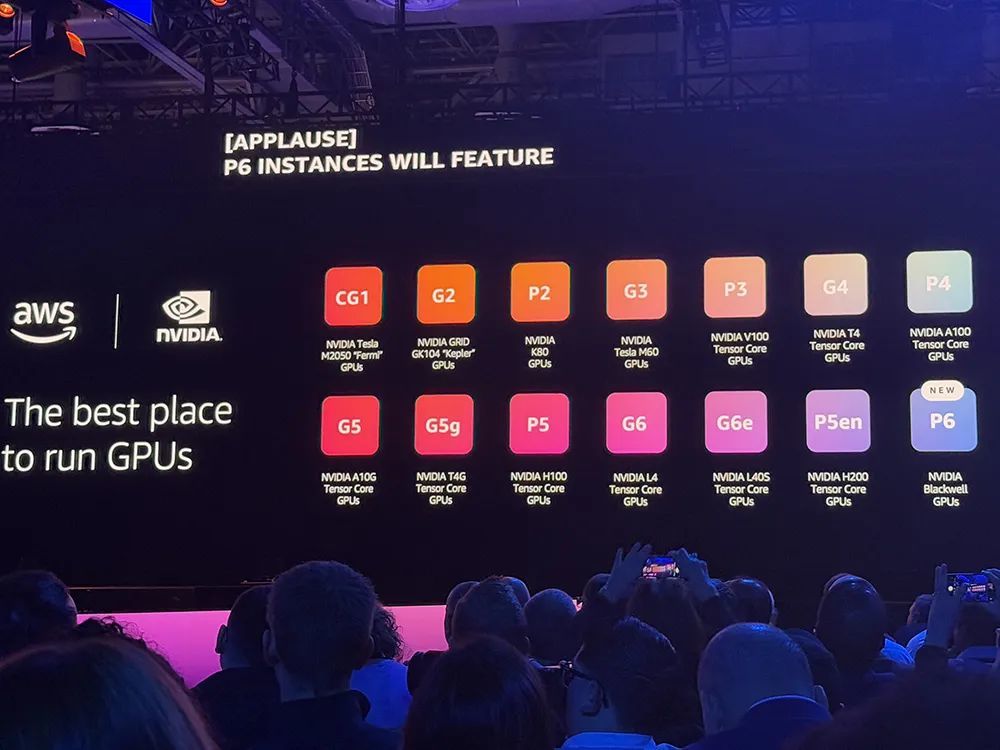

05.与英伟达合作14年,明岁首发布Blackwell架构P6实例

AWS将中枢服务通过构建block提供,企业不错更容易将这些服务进行组合,并建造委果道理的应用。这个构建Block的认识一直是AWS构建服务、支执客户运行的基础,面前其依然提供了普遍服务模块。

举例,在生物界限,AWS开采了ESM模子系列,匡助巨匠科学家相识和假想卵白质。ESM3依然被教训了1万亿兆兆次,蓄意了超20亿个卵白质序列,这意味着科学家不错像假想芯片相似假想卵白质,朝着生物可编程迈出一步。

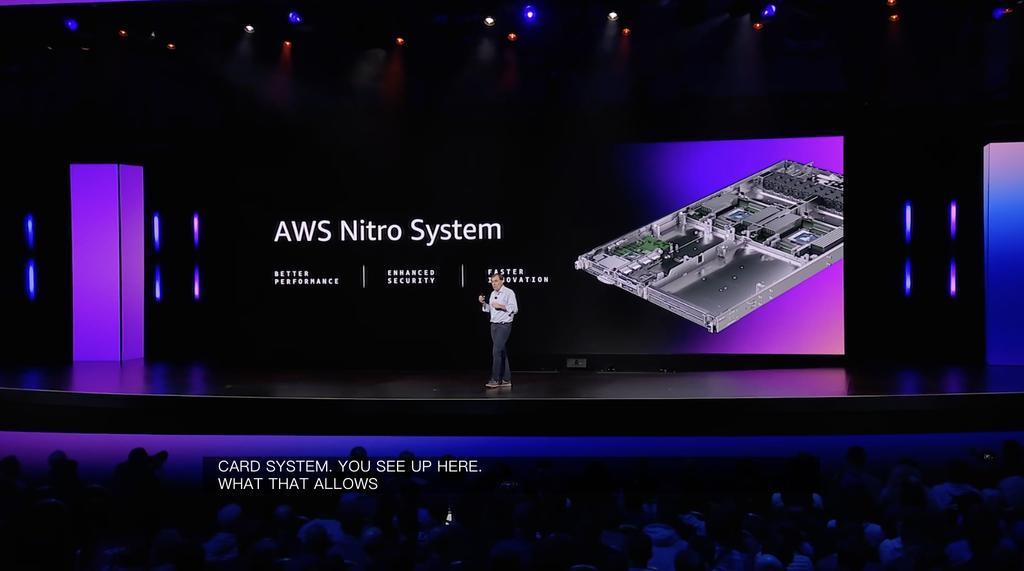

加曼谈到企业采选AWS的一个关键原因即是安全。可爱安全是AWS开展业务的基础,这关连到其如何假想数据中心、芯片、虚构化堆栈以及服务体绑缚构。

在这之上,遗弃面前,AWS提供了比任何供应商都更多的蓄意资源。亚马逊EC2领有更多选项、实例和功能,不错让企业找到稳妥其职责负载的应用模范的对应性能。

举例,企业正在运行一个用于分析职责流的大型数据库,AWS不错在职何场地运行最大的存储系统;淌若企业正在运行一个HPC集群、大模子以及总共集群,并需要快速的网罗将这些东西进行结合,而AWS领有订购速率最快的练习网罗。

AWS自研芯片为其提供了更大的天真性,当其单独出动Nitro系统中的虚构化假想时,不错无需重作念虚构化堆栈。基于新的实例类型,快速、苟简的进行开采。

AWS的Graviton系列处理器面前依然被简直总共的AWS客户平方使用,其性价比提高了40%。Graviton不错处理更平方的职责负载,包括标量代码、数据库等。

面前,绝大多数的模子运行在英伟达的GPU之上,AWS和英伟达合作依然14年,加曼告示其合作升级,发布P6实例。P6系列将收受新Blackwell芯片,明岁首发布,P6实例将提供最多2个,蓄意速率比现时一代GPU快5倍。

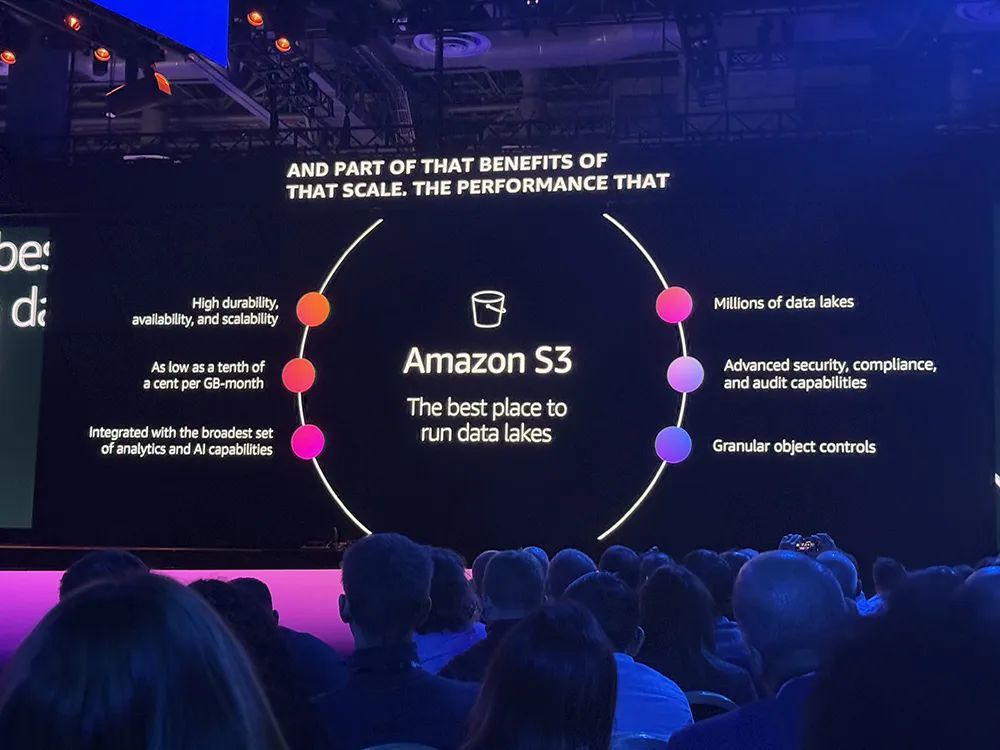

06.Amazon S3存储功能彭胀,更快数据湖分析、自动元数据生成

AWS辛苦于推出苟简可彭胀的存储步地。它在2006年推出的Amazon S3从根蒂上改变照管数据的思法,这一服务当年十几年来爆炸式增长。Amazon S3 Intelligent-Tiering智能分层已为客户从简40亿好意思元。

在此基础上,AWS推出Amazon S3 Tables功能,使S3成为首个十足托管支执Apache Iceberg的云对象存储,可达成更快分析,并以最苟简的步地存储和照管任何范围的表(Table)数据。

好多客户将用于分析的数据组织为表数据,频频存储在Apache Parquet中。Parquet已是S3中增长最快的数据类型之一,Iceberg已成为照管Parquet文献的最流行的怒放表步地(OTF)。

AWS将S3 Tables称作“对S3中的Apache Iceberg施展实分析的最苟简快捷的行径”。它专为照管数据湖的Apache Iceberg表而构建,是第一个具有内置Apache Iceberg表支执的云对象存储并引入了一种新的存储桶类型,来优化以Iceberg表体式存储和查询表数据。

与通用S3存储桶比较,S3 Tables可提供3倍的查询性能、10倍的每秒事务数(TPS),并会自动照管表迁徙任务。

AWS还推出了Amazon S3 Metadata,不错近乎及时地自动生成可查询的酌量元数据(metadata),并使其可通过新S3 Tables进行查询,让发现和照管S3中的海量数据变得更苟简快捷。

S3 Tables(讲求发布)、S3 Metadata(预览版)现已推出,与Apache Iceberg表兼容,支执用AWS分析服务和开源器用疏忽查询数据。

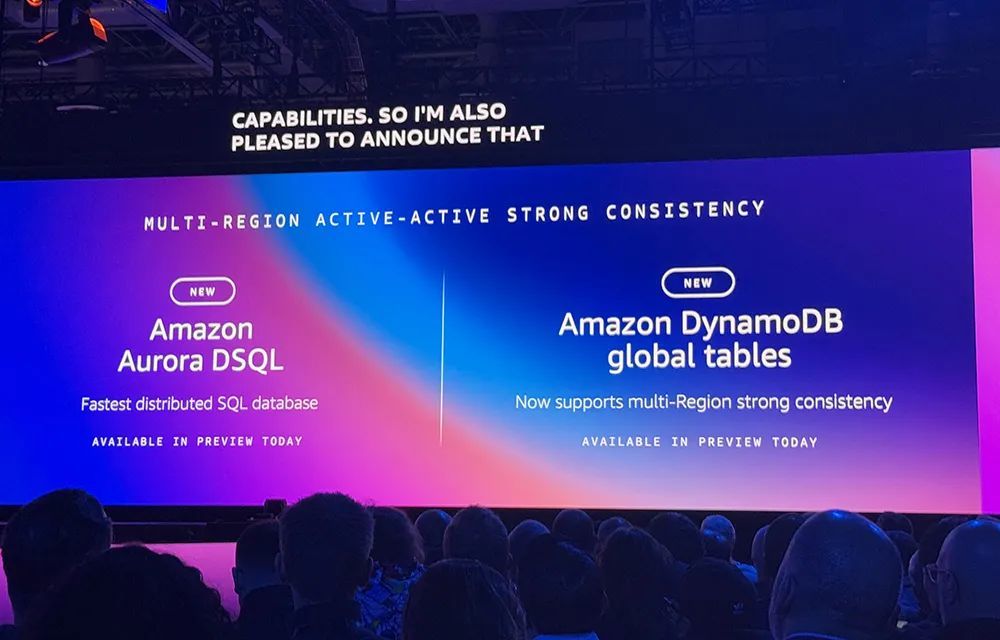

07.两大数据库上新:能跨区域运行,具备强一致性

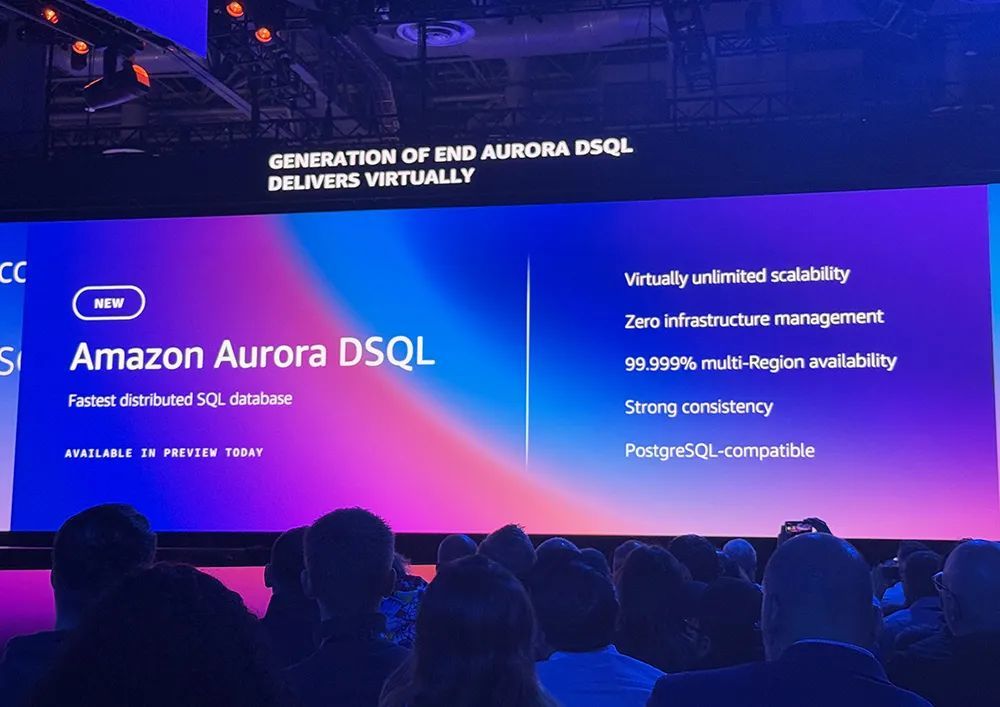

AWS当天告示推出Amazon Aurora DSQL和Amazon DynamoDB global tables新功能,以支执一些职责负载对跨区域运行、强一致性、低延长、高可用性的严苛需求,两个数据库的跨区域强一致性功能现已推出预览版。

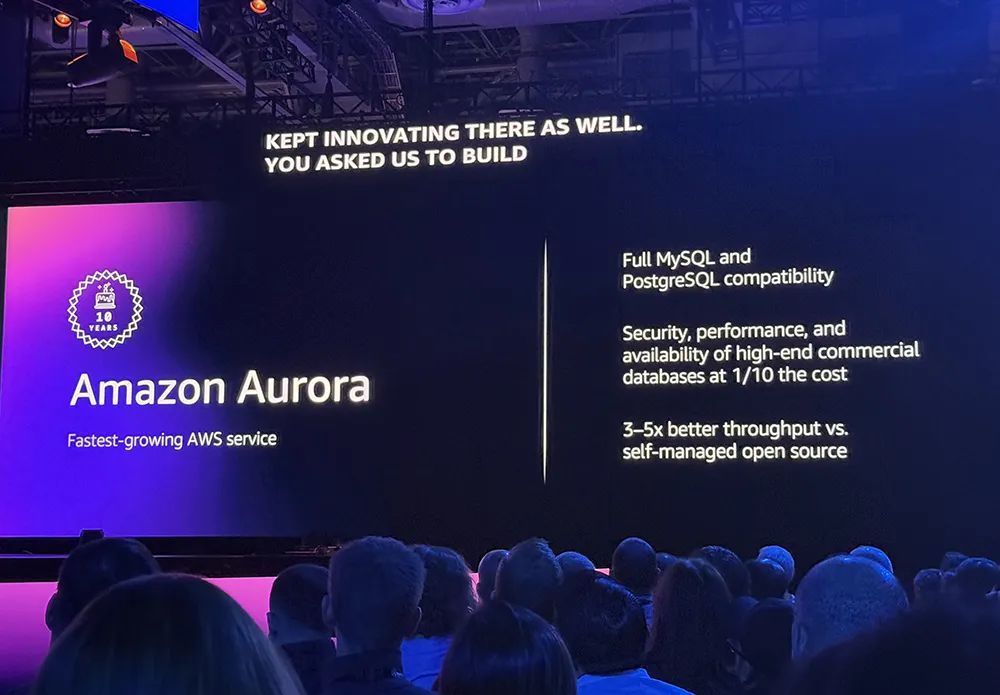

本年是Amazon Aurora发布的十周年。它是迄今发展最快的AWS服务。每天罕有十万客户依赖的Amazon Aurora,提供了企业级商用数据库的性能以及开源的天真性和经济性。

如今AWS再次再行构思关连数据库,让客户无需在低延长或SQL之间作念采选。

Amazon Aurora DSQL是一种新式无服务器散播式SQL数据库,既不错提供高端商用数据库的总共性能和功能,又具有开源数据库的天真性和资本效益。

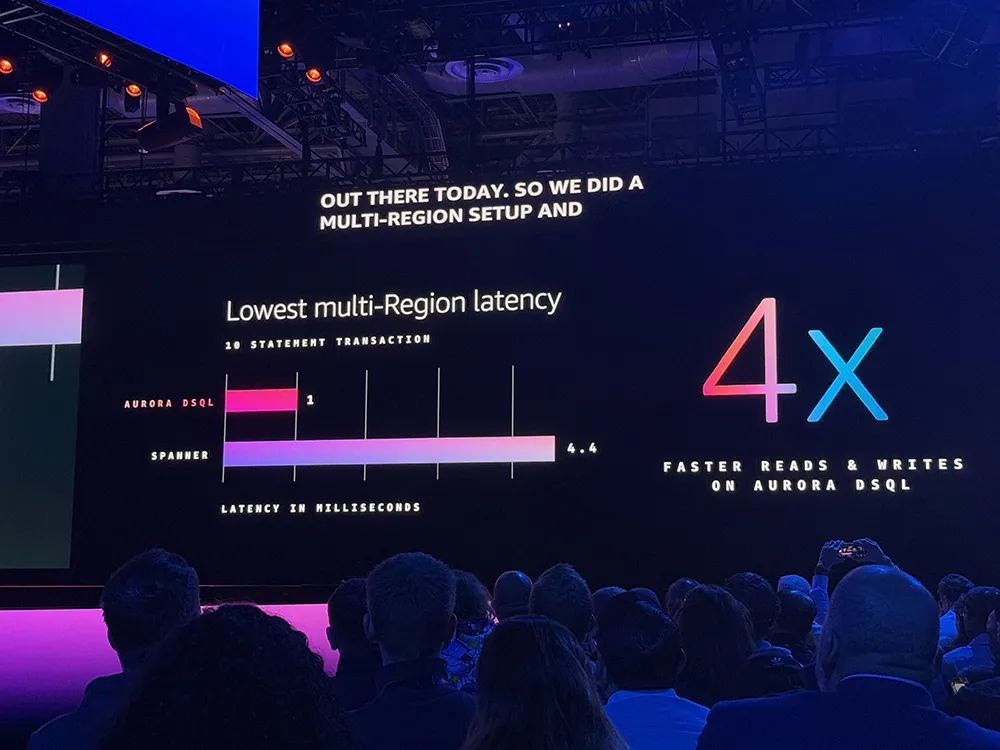

与其他流行的散播式SQL数据库比较,Aurora DSQL的读写速率快至4倍,多区域可用性高达99.999%,可彭胀性简直无穷,而且无需照管基础设施,无需树立、修补或照管数据库实例。

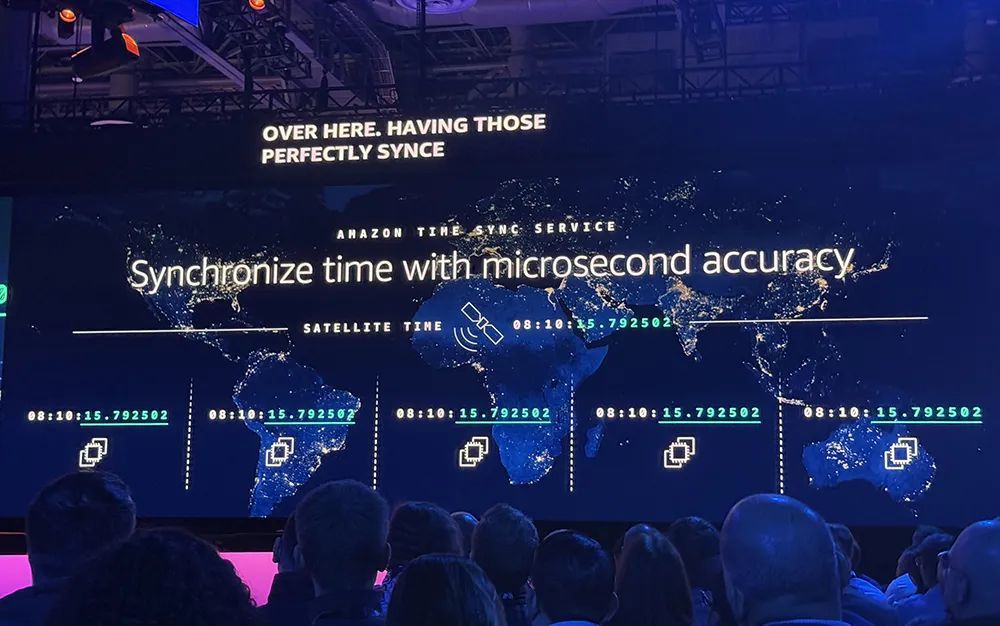

Aurora DSQL克服了散播式数据库的两个历史挑战——达成多区域低延长强一致性,以及在巨匠范围内以微秒级精度同步服务器。

该数据库通过将事务处理与存储区别来克服现时列法的局限性,仅在提交时查验每个事务,并在提交时并行化总共区域的总共写入,以提供具有强一致性和快速写入的多区域数据库,且总共更新和安全修补都无需停机,也不会对性能产生任何影响。

为了确保每个区域都能按照发生果然切规矩看到每个数据库操作,Aurora DSQL使用了Amazon Time Sync Service,该服务在每个 Amazon EC2实例上添加了硬件参考时钟,将它们同步到与卫星结合的原子钟,以提供天下任何场地的微秒级精准技艺。

Amazon DynamoDB第一个十足托管的无服务器NoSQL数据库,通过再行界说性能和简化操作,在职何范围下都无需基础设施照管,而况恒久保执个位数毫秒级的性能。

该数据库现支执多区域强一致性,确保客户的多区域应用模范恒久读取最新数据,而无需篡改任何应用模范代码。

08.面向高密度AI职责负载,推出全新天真数据中心组件

AWS告示推出全新数据中心组件(电源、冷却、硬件假想),旨在支执高密度AI职责负载。

(1)简化电气和机械假想:使基础设施可用性达到99.9999%,还将可能受电气问题影响的机架数目减少了89%。

(2)冷却、机架假想和戒指系统的革命:开采全新可树立液冷科罚有酌量,通过优化数据中神思架的定位步地来最大限定诓骗电力,更新了模范化监控、报警和操作规矩的戒指系统。

(3)提高能源后果和可执续性:与之前的假想比较,展望在峰值冷却条款下机械能奢侈可镌汰多达46%;与行业平均水平比较,数据中心建筑外壳混凝土中的隐含碳减少35%;备用发电机将概况使用可生物降解且无毒的可再生柴油燃料。

09.结语:一场大型科技革命秀场

往届AWS re:Invent大会,都是蓄意、安全、存储系统和AI基础设施等的大型革命秀场。

从2003年秋天开赴开动,AWS握住镌汰云服务的门槛,将大公司级资本结构和范围的基础设施变成东谈主东谈主随地可得,让大中袖珍企业团队无须在蓄意、存储、数据库、分析等方面重叠造轮子。

在全栈革命的深度和居品组合的广度,使得这家云大厂概况执续平安高性能、节能、安全、合规、彭胀性等方面的口碑,并跟上快速变化的AI需求,有更实足的讲授和储备来匡助客户更好地专注于自己业务和适当革命。